关于网站伪静态这一块,很早之前我就在许多平台发布过相关的文章,今天应菜狗君之约,今天回顾整理一下。

此次“伪静态系列”总共有三篇:

一、网站伪静态后怎样写robots屏蔽动态页面

二、伪静态使用不当易生成大量重复收录页面

三、分享伪静态页面不如动态页面的原因

今天一起分享出来:

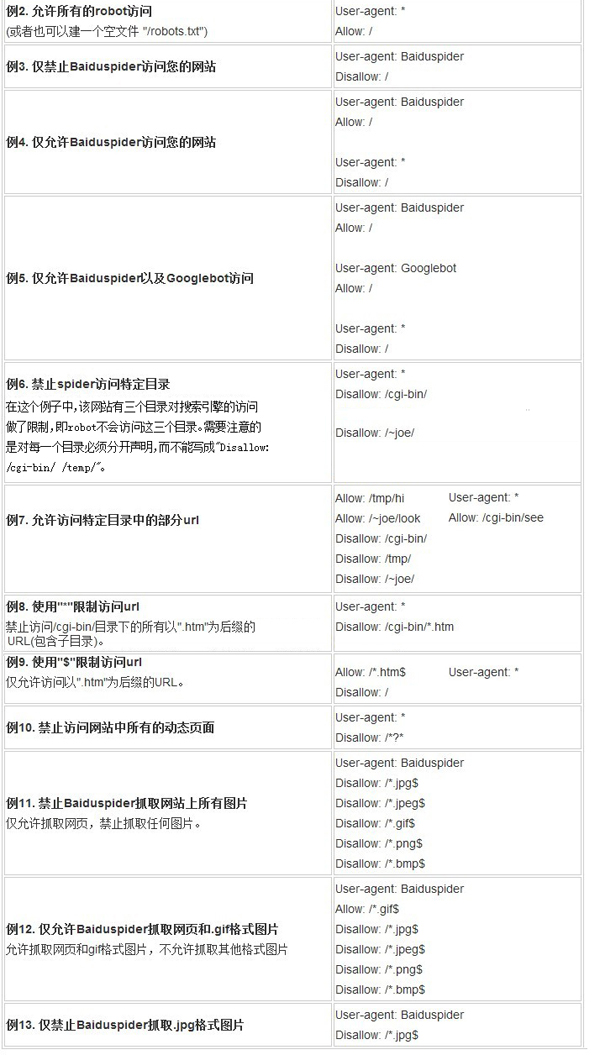

许多站长在建设网址之后,没有来得及伪静态就直接上线,之后伪静态但是百度收录了很多的动态页面。那么我们的网站伪静态后怎样写robots屏蔽动态页面呢?我在很多书籍和网站上没有找到详细的解答方案,伪静态后怎样写robots屏蔽动态页面是一个炙手可热的问题,也是许多站长很头疼的事情。因为这直接导致你的动态页面是否被收录,如果被收录会出现一个重复的静态页面,如果重复页面过多势必导致降权。那么我们伪静态后怎样写robots屏蔽动态页面呢?

首先,我们要做的是查清楚,哪些页面是没有进行过伪静态的。在我之前做的一个伪静态的文件中,网页的页数就没有写伪静态,导致这个页面的第二页和第三页以后的页面全是动态的。所以,这个问题是不可忽视的问题,在iis服务器或apache服务器里面重写规则的时候记得要带上页码的代码。

其次,robots.txt文件的规范性。许多同学估计在开头就没有进行空格。这个空格在哪里呢?例如,robots.txt文件的开头:

“User-agent: *

Disallow: /plus/ad_js.php”

很多的时候,user-agent分号后面没有空格,而是直接“*”号了。这就是一个很微小的错误,但是也是致命的错误。

![]()

![]()

最后,要注意的是,我们知道php动态页面都是从数据调用的数据,而这个网页不是真实存在的,所以搜索引擎久而久之就会丢弃这样的页面,它会认为这是不可靠的页面。所以我们要屏蔽这样的动态页面,从而降低我们网页的重复页面。那么我们只要在robots.txt文件里面,加上这样的代码就行了:"Disallow:/*?*”。这个代码的意思是根目录下个所有动态禁止搜索引擎访问。

讲了这么多,站长朋友们是否明白伪静态后怎样写robots屏蔽动态页面呢?网站伪静态之后一定要反复检查,哪些页面没有静态化的,导致出现重复页面。